https://doi.org/10.35381/r.k.v10i20.4635

Valoración de las competencias investigativas según perfil de uso de inteligencia artificial en educación superior

Assessment of research skills according to the profile of artificial intelligence use in higher education

César Henry Andrade-Moreira

Escuela Superior Politécnica Agropecuaria de Manabí Manuel Félix López, Calceta, Manabí, Ecuador

https://orcid.org/0000-0002-2832-5312

Marys Beatriz Iriarte-Vera

Escuela Superior Politécnica Agropecuaria de Manabí Manuel Félix López, Calceta, Manabí, Ecuador

https://orcid.org/0000-0002-0732-5970

Andres Antonio Zambrano-Carreño

andres_zambrano_mca@espam.edu.ec

Escuela Superior Politécnica Agropecuaria de Manabí Manuel Félix López, Calceta, Manabí, Ecuador

https://orcid.org/0009-0005-9611-8541

Recibido: 15 de marzo 2025

Revisado: 10 de abril 2025

Aprobado: 30 de junio 2025

Publicado: 01 de julio 2025

RESUMEN

La inteligencia artificial (IA) ha experimentado un crecimiento acelerado, consolidándose como un recurso estratégico para la educación universitaria. Este estudio tuvo como objetivo examinar las competencias investigativas de estudiantes de educación superior en función de su perfil de uso de IA, a fin de generar información que sustente la toma de decisiones en materia curricular y de gestión académica. Se empleó un enfoque cuantitativo, no experimental, transversal y descriptivo, con una muestra de 70 estudiantes seleccionados mediante muestreo no probabilístico por conveniencia. Se aplicó un cuestionario validado para medir competencias investigativas y frecuencia de uso de IA. Los resultados muestran un alto uso de la IA, con mayor incidencia en el análisis e interpretación de información y menor efecto en la formulación del problema y fundamentación teórica. Se concluye que se requiere promover un uso más crítico y reflexivo de la IA en la investigación académica.

Descriptores: Inteligencia artificial; investigación científica; innovación educacional; educación superior. (Tesauro UNESCO).

ABSTRACT

Artificial intelligence (AI) has experienced rapid growth, establishing itself as a strategic resource for higher education. This study aimed to examine the research competencies of university students based on their AI usage profile, in order to generate information that supports decision-making in curricular and academic management. A quantitative, non-experimental, cross-sectional, and descriptive approach was employed, with a sample of 70 students selected through non-probabilistic convenience sampling. A validated questionnaire was applied to measure research competencies and frequency of AI use. The results show high AI usage, with the greatest impact on information analysis and interpretation, and a lesser effect on problem formulation and theoretical grounding. It is concluded that promoting a more critical and reflective use of AI in academic research is necessary.

Descriptors: Artificial intelligence; scientific research; educational innovation; higher education. (UNESCO Thesaurus).

INTRODUCCIÓN

La rápida expansión de la inteligencia artificial, en especial de los sistemas generativos, ha transformado la educación superior, generando debates sobre su papel estratégico o instrumental y la necesidad de liderazgo, políticas claras y uso responsable con transparencia y pensamiento crítico (Bollaert, 2025; Duque-Rodríguez et al., 2024). A la par, emergen evidencias de una alianza complementaria entre el acompañamiento del supervisor y el soporte de la IA generativa que enriquece la experiencia investigativa sin sustituir el valor insustituible de la interacción humana (Huang et al., 2025).

Dentro de la literatura, Behnamnia et al. (2024) investigaron cómo la integración de una plataforma con IA (BrainPOP) en educación superior, combinada con competencias digitales docentes y un entorno de apoyo, fortalece las habilidades investigativas, evidenciando correlaciones positivas y estrategias efectivas de integración. En un estudio cuasi-experimental, Gonzales et al. (2025) demostraron que 15 sesiones con ChatGPT mejoraron significativamente seis dimensiones de la competencia investigativa en estudiantes de pregrado, con alta potencia explicativa del modelo. De manera complementaria, Berrios y Márquez (2025) evaluaron una estrategia pedagógica asistida por agentes generativos, encontrando avances sustantivos en idea, planteamiento, diseño y análisis respecto al grupo control.

Deroncele et al. (2024) propusieron un marco de “diez pilares” ética, integración didáctica, aprendizaje automático, procesamiento de lenguaje natural, realidad aumentada, sistemas tutoriales inteligentes, entre otros para guiar la adopción de IA en la educación universitaria en ciencias.. Finalmente, Aguirre et al. (2024) exploraron actitudes en posgrado, hallando percepciones ambivalentes que reconocen la utilidad de la IA, pero también subrayan la necesidad de responsabilidad y habilidades especializadas para su uso adecuado.

Con todo, la literatura advierte beneficios y riesgos: la IA habilita análisis avanzados, automatiza tareas y fomenta colaboración interdisciplinaria, pero también introduce sesgos algorítmicos, riesgos de privacidad y dependencias que pueden erosionar el juicio crítico; por ello, se recomiendan programas de formación, acceso equitativo y lineamientos éticos para resguardar la pericia humana (El Hani et al., 2025; Comas Rodríguez, 2025). En consecuencia, la integridad de la investigación no puede tratarse como un asunto externo, sino integrado al propio entrenamiento investigativo, con atención especial a la “zona gris” de prácticas cuestionables y a la actualización de perfiles de competencia que ya incorporen el impacto de la IA (Selan y Metljak, 2023; Bracho Fuenmayor, 2023).

En suma, la confluencia entre IA y competencias investigativas abre oportunidades para elevar la calidad y la eficacia del trabajo académico, pero plantea exigencias de alfabetización crítica, supervisión humana significativa y marcos éticos robustos. Persisten, sin embargo, vacíos sobre cómo varían las competencias investigativas según los perfiles de uso de IA en educación superior, lo que lleva a formular la pregunta: ¿Cómo varían las competencias investigativas de los estudiantes de educación superior según su perfil de uso de inteligencia artificial? En este sentido, el presente estudio tiene como objetivo examinar las competencias investigativas de los estudiantes de educación superior en función de su perfil de uso de inteligencia artificial, a fin la generación de información que sustente la toma de decisiones en materia curricular y de gestión académica.

MÉTODO

La investigación adoptó un enfoque cuantitativo, de tipo no experimental, transversal y descriptivo. Se emplearon métodos teóricos como el inductivo-deductivo, y analítico-sintético para la generación análisis y determinar hallazgos relevantes. La población estuvo conformada por estudiantes de educación superior que cursan la carrera de Administración de Empresas de la Escuela Superior Politécnica de Manabí “Manuel Félix López” (ESPAM MFL).

Para la selección de participantes se utilizó un muestreo no probabilístico por conveniencia durante el periodo académico abril-agosto 2025. Por tanto, se determinó un total de 70 estudiantes donde 33 estudiantes fueron de noveno semestre y 37 de séptimo semestre, considerando criterios de accesibilidad, disposición voluntaria y disponibilidad horaria.

La recolección de datos se usó la técnica de la encuesta, donde se utilizó el instrumento validado para evaluar competencias investigativas de Ríos et al. (2023). La escala evalúa el nivel de dominio de cada habilidad para la investigación científica en cinco niveles: 1 = Ninguno, 2 = Poco, 3 = Regular, 4 = Elevado y 5 = Total. Los ítems instruyen al participante a examinar cada habilidad y marcar el número que mejor representa lo que sabe hacer.

Dentro de la estructura del instrumento se incluyó determinar la frecuencia de uso de IA para la segmentación de la muestra en tres grupos (bajo, moderado y alto uso). Esta simplificación permite clasificar a los participantes para el análisis de grupos y ANOVA, sin afectar la medición principal de competencias. Cada ítem se valoró mediante una escala de Likert de 5 puntos, cuya utilidad en la medición de actitudes y percepciones ha sido respaldada por Robie et al.(2022).

Para el análisis, la escala de frecuencia de cinco niveles se recodificó en tres grupos con el fin de facilitar la formación de clústeres y permitir comparaciones estadísticas como ANOVA. Se agruparon las categorías 1 y 2 en bajo uso, la categoría 3 en uso moderado; y las categorías 4 y 5 se unificaron en alto uso. Esta transformación responde a criterios metodológicos propios del análisis de grupos. Según Peña (2002), como se citó en De La Hoz y López (2017) reducir categorías con pocos casos mejora la homogeneidad interna y la eficacia del agrupamiento, evitando distorsiones y permitiendo identificar patrones.

El procesamiento y análisis de datos se realizó con el software estadístico SPSS v25. Se evaluó la confiabilidad del instrumento mediante el coeficiente Alfa de Cronbach, siguiendo el procedimiento con el respaldo teórico de Taber (2018) quienes destacan su relevancia para determinar la consistencia interna. Cabe precisar que, con 19 reactivos correspondientes a la escala original, se obtuvo un coeficiente de .0947, siendo un nivel de consistencia interna excelente.

Para determinar si existían diferencias significativas en las competencias investigativas según los perfiles de uso de inteligencia artificial, se aplicó un análisis de varianza (ANOVA) de un factor. Previamente, se verificaron los supuestos de homogeneidad de varianzas (Levene, 1960), donde se determinó que era posible realizar el ANOVA de un factor.

RESULTADOS

En esta sección se presentan los resultados del análisis de los datos relacionados con las competencias investigativas. La organización de la sección incluye los aspectos siguientes:

a) análisis descriptivo por reactivo de cada dimensión;

b) análisis de las puntuaciones promedio por dimensiones;

c) Perfiles de nivel de uso de IA;

d) resultados del análisis de varianza (ANOVA), que muestra la comparación de las competencias investigativas entre niveles de uso de inteligencia artificial; y

e) comparación de competencias investigativas por perfil de uso de IA.

Dimensión: Planteamiento del problema

Tabla 1.

Niveles de dominio en la formulación del problema.

|

Ítem |

Capacidad |

Promedio |

|

1 |

Detectar temas o áreas de interés que requieran investigarse desde el punto de vista científico |

3.20 |

|

2 |

Formular el problema de investigación, reduciéndolo a sus aspectos y relaciones esenciales |

3.24 |

|

3 |

Delimitar el problema de investigación tomando en cuenta las variables, ámbito espacial y temporal y población |

3.31 |

Elaboración: Los autores.

En la dimensión planteamiento del problema que se plantea en la tabla 1, los estudiantes muestran un dominio de regular a elevado. La delimitación del problema alcanza el promedio más alto (3,31), seguida de la formulación (3,24) y la detección de temas de interés (3,20), todas en rango regular. Esto indica una base sólida para iniciar investigaciones, aunque aún es necesario reforzar la precisión y profundidad en la identificación y formulación de problemas.

Dimensión: Fundamentación teórica

Tabla 2.

Niveles de dominio en fundamentación teórica.

|

Ítem |

Capacidad |

Promedio |

Nivel de dominio |

|

4 |

Evaluar críticamente el estado del conocimiento para identificar avances, vacíos o contradicciones |

3.14 |

Regular |

|

5 |

Construir el marco referencial con investigaciones recientes y teorías más relevantes |

3.36 |

Regular |

Elaboración: Los autores.

En la dimensión de fundamentación teórica, los estudiantes presentan un dominio regular en ambas capacidades (Tabla 2). La evaluación crítica del estado del conocimiento obtuvo un promedio de 3,14, lo que indica que identifican avances, vacíos o contradicciones, pero con limitaciones en profundidad. La construcción del marco referencial alcanzó 3,36, evidenciando un manejo aceptable de investigaciones recientes y teorías relevantes.

Dimensión: Diseño metodológico

Tabla 3.

Niveles de dominio en el diseño metodológico.

|

Ítem |

Capacidad |

Promedio |

|

6 |

Especificar el tipo de investigación (paradigma, diseño, enfoque, alcance) |

3.33 |

|

7 |

Seleccionar la muestra o informantes según el enfoque de investigación |

3.39 |

|

8 |

Determinar instrumentos y técnicas para recolección de datos apropiados |

3.37 |

|

9 |

Desarrollar instrumentos de recolección considerando confiabilidad y validez |

3.43 |

Elaboración: Los autores.

En la dimensión diseño metodológico, los promedios muestran un dominio regular cercano a elevado (Tabla 3). La capacidad mejor valorada es el desarrollo de instrumentos considerando confiabilidad y validez (3,43), seguida de la selección de la muestra (3,39) y la determinación de instrumentos y técnicas de recolección de datos (3,37). Especificar el tipo de investigación presenta un promedio ligeramente menor (3,33), aunque se mantiene en el mismo rango. Estos resultados indican que los estudiantes cuentan con una base metodológica adecuada, pero requieren fortalecer la precisión en la definición del diseño y en la aplicación rigurosa de los procedimientos de recolección.

Dimensión: Análisis e interpretación.

Tabla 4.

Niveles de dominio en el análisis e interpretación.

|

Ítem |

Capacidad |

Promedio |

|

10 |

Analizar datos cuantitativos utilizando métodos y técnicas estadísticas |

3.33 |

|

11 |

Analizar información cualitativa con métodos como análisis de contenido |

3.43 |

|

12 |

Aplicar métodos mixtos de investigación integrando análisis cuali-cuantitativo |

3.34 |

|

13 |

Interpretar resultados de acuerdo con el marco referencial |

3.43 |

Elaboración: Los autores.

En la dimensión análisis e interpretación, los resultados evidencian un dominio regular cercano a elevado en las capacidades evaluadas (Tabla 4). Los puntajes más altos se observan en el análisis de información cualitativa (3,43) y en la interpretación de resultados según el marco referencial (3,43), lo que indica mayor seguridad en el manejo de datos no numéricos y en la vinculación de hallazgos con la teoría. El análisis de datos cuantitativos (3,33) y la aplicación de métodos mixtos (3,34) presentan valores ligeramente menores, aunque dentro del mismo rango, lo que sugiere que el trabajo con herramientas estadísticas y la integración de enfoques requieren fortalecimiento para una interpretación más integral y rigurosa de los resultados.

Dimensión: Comunicación científica

Tabla 5.

Niveles de dominio en la comunicación científica.

|

Ítem |

Capacidad |

Promedio |

|

14 |

Redactar informes académicos o científicos para presentación oral o escrita |

3.34 |

|

15 |

Seguir normas de edición (APA, Chicago, Vancouver) según disciplina o institución |

3.27 |

|

16 |

Elaborar conclusiones tomando en cuenta los resultados del estudio |

3.33 |

|

17 |

Formular recomendaciones para futuras investigaciones |

3.64 |

|

18 |

Relacionar componentes de investigación para mantener coherencia |

3.43 |

|

19 |

Considerar criterios de rigor científico para fundamentar credibilidad |

3.41 |

Elaboración: Los autores.

En la dimensión comunicación científica, los resultados muestran un dominio mayormente regular con tendencia a elevado (Tabla 5). La capacidad mejor valorada corresponde a la formulación de recomendaciones para futuras investigaciones (3,64), seguida por la coherencia en la relación entre los componentes del estudio (3,43) y la consideración de criterios de rigor científico (3,41), lo que refleja una adecuada proyección de los hallazgos y cuidado por la calidad del trabajo. En niveles ligeramente inferiores, aunque aún regulares, se ubican la redacción de informes académicos (3,34), la elaboración de conclusiones basadas en resultados (3,33) y el seguimiento de normas de edición (3,27), este último como aspecto que podría requerir más fortalecimiento para asegurar la correcta presentación formal de los trabajos.

Niveles de dominio en competencias investigativas según dimensiones

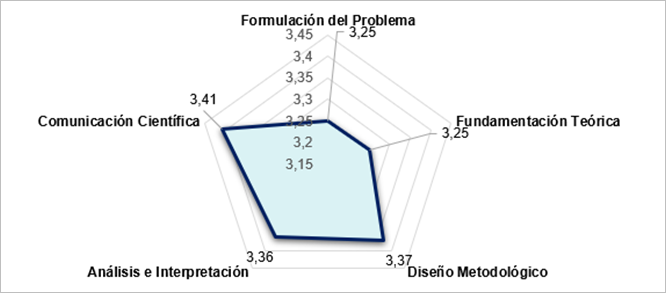

En la figura 1 se presentan los niveles de dominio de las competencias investigativas distribuidos por dimensiones, lo que permite identificar en qué áreas los estudiantes muestran mayor o menor fortaleza.

Figura 1. Evolución temporal de las temáticas.

Elaboración: Los autores.

En términos generales, las competencias investigativas de los estudiantes se ubican mayormente en un nivel regular, lo que implica un conocimiento básico con aplicación parcial. La comunicación científica alcanza el valor más alto (3,41), cercana al nivel “elevado”, reflejando mayor seguridad en la presentación de resultados, coherencia y rigor. Le siguen el diseño metodológico (3,37) y el análisis e interpretación (3,36), con un manejo adecuado para planificar investigaciones y procesar datos en la mayoría de situaciones. En contraste, la formulación del problema y la fundamentación teórica (3,25) son las áreas más bajas, indicando necesidad de fortalecer la precisión en la identificación del problema y en la construcción del marco conceptual para elevar el dominio general.

Perfil de uso de IA en los estudiantes

Tabla 7.

Nivel de uso de Inteligencia artificial (IA).

|

Grupo |

Frecuencia |

% del Total |

|

Alto uso |

47 |

67.1 % |

|

Uso moderado |

22 |

31.4 % |

|

Bajo uso |

1 |

1.4 % |

Elaboración: Los autores.

En la tabla 7, se muestra que la distribución del nivel de uso de inteligencia artificial revela que la mayoría de estudiantes se ubica en el grupo de alto uso (67,1 %), lo que indica una interacción frecuente o intensiva con estas herramientas en su contexto académico. Un 31,4 % presenta uso moderado, reflejando un empleo ocasional y probablemente focalizado en tareas específicas. Solo un 1,4 % reporta bajo uso, lo que evidencia que la baja adopción de IA es marginal en la muestra. Este patrón sugiere que, en general, la población estudiada incorpora la IA de forma habitual en sus actividades, lo que podría influir en el desarrollo y aplicación de sus competencias

Comparación de las competencias investigativas entre niveles de uso de inteligencia artificial

Para verificar el cumplimiento del supuesto de igualdad de varianzas previo a la aplicación del análisis de varianza (ANOVA), se utilizó la prueba de Levene considerando diferentes estimaciones (media, mediana, mediana con gl ajustado y media recortada). Sin embargo, para efectos de interpretación estadística se planteó en la tabla 8 presentar el valor de significancia para determinar la homogeneidad correspondiente.

Tabla 8.

Prueba de homogeneidad.

|

Dimensión |

Sig. (basada en la media) |

Homogeneidad de varianzas |

|

Formulación del problema |

0,254 |

Sí |

|

Fundamentación teórica |

0,747 |

Sí |

|

Diseño metodológico |

0,196 |

Sí |

|

Análisis e interpretación |

0,908 |

Sí |

|

Comunicación científica |

0,945 |

Sí |

Elaboración: Los autores.

Todos los valores de significancia son mayores a 0,05, por lo que no se rechaza la hipótesis de igualdad de varianzas. El supuesto de homogeneidad se cumple en todas las dimensiones, lo que permite aplicar el ANOVA de un factor. De tal manera que en la tabla 9 se presenta el modelo ANOVA calculado mediante SPSS.

Tabla 9.

Resultados del análisis de varianza (ANOVA) de las competencias investigativas según el nivel de uso de inteligencia artificial

|

|

Suma de cuadrados |

Gl |

Media cuadrática |

F |

Sig. |

|

|

Formulación del problema |

Entre grupos |

1,300 |

2 |

,650 |

2,212 |

,117 |

|

Dentro de grupos |

19,686 |

67 |

,294 |

|

|

|

|

Total |

20,986 |

69 |

|

|

|

|

|

Fundamentación teórica |

Entre grupos |

,575 |

2 |

,288 |

,658 |

,521 |

|

Dentro de grupos |

29,300 |

67 |

,437 |

|

|

|

|

Total |

29,875 |

69 |

|

|

|

|

|

Diseño metodológico |

Entre grupos |

1,823 |

2 |

,911 |

2,095 |

,131 |

|

Dentro de grupos |

29,145 |

67 |

,435 |

|

|

|

|

Total |

30,968 |

69 |

|

|

|

|

|

Análisis e interpretación |

Entre grupos |

4,404 |

2 |

2,202 |

4,790 |

,011 |

|

Dentro de grupos |

30,801 |

67 |

,460 |

|

|

|

|

Total |

35,204 |

69 |

|

|

|

|

|

Comunicación científica |

Entre grupos |

2,033 |

2 |

1,017 |

2,335 |

,105 |

|

Dentro de grupos |

29,175 |

67 |

,435 |

|

|

|

|

Total |

31,208 |

69 |

|

|

|

|

Elaboración: Los autores.

El ANOVA aplicado para contrastar las competencias investigativas entre los tres perfiles de uso de IA (bajo, moderado y alto) muestra que solo la dimensión “análisis e interpretación” presenta diferencias estadísticamente significativas (F = 4,790; p = 0,011), lo que indica que el nivel de esta habilidad varía según la frecuencia de uso de herramientas de IA. Esto sugiere que quienes usan IA con mayor frecuencia podrían desarrollar o potenciar competencias relacionadas con el manejo, procesamiento y comprensión de datos.

En contraste, las dimensiones de formulación del problema (p = 0,117), fundamentación teórica (p = 0,521), diseño metodológico (p = 0,131) y comunicación científica (p = 0,105) no evidencian diferencias significativas, lo que implica que el uso de IA no se asocia de manera directa con variaciones relevantes en estas áreas. En conjunto, los resultados indican que el impacto del uso de IA sobre la competencia investigativa es más notoria en la fase analítica del proceso de investigación, antes que en las etapas de planificación, fundamentación o difusión.

Distribución de las competencias investigativas según el perfil de uso de inteligencia artificial

Esta sección presenta la comparación de las competencias investigativas según el perfil de uso de inteligencia artificial (IA) identificado en los participantes. Por ende, la tabla 10 se presenta la distribución según el perfil de uso.

Tabla 10.

Competencias investigativas por perfil de uso de IA.

|

Perfil de uso |

Formulación del problema |

Fundamentación teórica |

Diseño metodológico |

Análisis e interpretación |

Comunicación científica |

|

|

Uso bajo |

Media |

4 |

4 |

4 |

4 |

4 |

|

N |

1 |

1 |

1 |

1 |

1 |

|

|

Desv. Desviación |

. |

. |

. |

. |

. |

|

|

Uso moderado |

Media |

3,09 |

3,23 |

3,16 |

3,00 |

3,18 |

|

N |

22,00 |

22,00 |

22,00 |

22,00 |

22,00 |

|

|

Desv. Desviación |

0,48 |

0,63 |

0,57 |

0,71 |

0,67 |

|

|

Alto uso |

Media |

3,31 |

3,24 |

3,47 |

3,52 |

3,52 |

|

N |

47,00 |

47,00 |

47,00 |

47,00 |

47,00 |

|

|

Desv. Desviación |

0,57 |

0,67 |

0,70 |

0,66 |

0,65 |

|

|

Total |

Media |

3,25 |

3,25 |

3,38 |

3,36 |

3,42 |

|

N |

70,00 |

70,00 |

70,00 |

70,00 |

70,00 |

|

|

Desv. Desviación |

0,55 |

0,66 |

0,67 |

0,71 |

0,67 |

|

Elaboración: Los autores.

Los resultados muestran que, en promedio, los estudiantes con alto uso de IA reportan un mayor nivel de dominio en cuatro de las cinco dimensiones evaluadas: Diseño metodológico (3,47), Análisis e interpretación (3,51) y Comunicación científica (3,51), todos ubicados en el rango regular alto, cercano al nivel elevado (4). El grupo de uso moderado presenta valores ligeramente menores en estas dimensiones, con medias entre 3,00 y 3,23, manteniéndose en un dominio regular. El único caso en el que el valor más alto no lo tiene el grupo de alto uso es Fundamentación teórica, donde las medias de uso moderado (3,22) y alto uso (3,24) no existe mayor variación. El grupo de uso bajo, representado solo por un participante, presenta puntajes de 4,0 en todas las dimensiones, correspondientes al nivel elevado, aunque este resultado no es estadísticamente generalizable por el tamaño de la muestra. En síntesis, la tendencia sugiere que un mayor uso de IA se asocia con un nivel ligeramente superior de competencias investigativas, particularmente en las fases metodológica, analítica y de comunicación.

DISCUSIÓN

Es importante destacar que en cuanto al perfil de uso de IA, la mayoría de estudiantes se concentra en el grupo de alto uso, lo que denota una presencia significativa de estas herramientas en el contexto académico. En cuanto a las competencias investigativas de los estudiantes se sitúan mayoritariamente en un nivel regular, existe un efecto diferencial del uso de la inteligencia artificial (IA) en la fase de análisis e interpretación, sin un impacto estadísticamente significativo en otras etapas como la formulación del problema o la fundamentación teórica. Esto se alinea parcialmente con lo señalado por Diaz-Vera et al. (2023) quienes encontraron que el uso de ChatGPT puede mejorar el rendimiento académico, pero advirtieron que su efecto podría depender del tipo de habilidad evaluada y del contexto de aplicación.

En este sentido, la IA se alinea a potenciar con mayor claridad aquellas competencias vinculadas al procesamiento y manejo de información, mientras que las habilidades conceptuales y de planteamiento inicial del estudio aún dependen de procesos cognitivos no completamente sustituidos ni reforzados por la herramienta. Por su parte, Ilieva et al. (2023) destacan que los chatbots inteligentes basados en IA pueden transformar las actividades pedagógicas al facilitar la interacción y la retroalimentación en tiempo real. Esto coincide con el mayor dominio observado en análisis e interpretación, dimensiones asociadas al trabajo con datos y herramientas de procesamiento. No obstante, la ausencia de diferencias en la fundamentación teórica sugiere que la IA aún presenta limitaciones para favorecer el aprendizaje profundo en el manejo de marcos conceptuales, posiblemente por la forma en que los estudiantes la incorporan en su práctica académica.

El trabajo de Pavlik (2023) subraya que el potencial transformador de la IA generativa no está exento de limitaciones, y que su uso requiere de un pensamiento crítico para evaluar la validez y confiabilidad de la información generada. Esta observación podría explicar por qué en el presente estudio, a pesar del alto uso de IA en la muestra, las dimensiones de planteamiento del problema y fundamentación teórica mantienen puntajes más bajos: la dependencia excesiva de respuestas automatizadas podría reducir la ejercitación de procesos de búsqueda, contraste y delimitación de problemas, que son esenciales para una formulación sólida.

Asimismo, se observó que el uso intensivo de la IA tiende a optimizar aspectos operativos y técnicos del trabajo de investigación, como el análisis de datos, aunque no necesariamente potencia las competencias de carácter más reflexivo y teórico. En una visión más amplia, Zawacki-Richter et al. (2019) que las aplicaciones de la IA en la educación superior se han concentrado principalmente en áreas como la evaluación y los sistemas adaptativos, manteniendo una débil vinculación con enfoques pedagógicos que integren las herramientas en el desarrollo integral de competencias.

Asimismo, el modelo propuesto por Soliman et al. (2024) para explicar la intención continua de uso de la IA en educación destaca factores como la facilidad de uso, la utilidad percibida y la satisfacción, lo cual podría relacionarse con la alta adopción de estas herramientas en la muestra de estudiantes. Sin embargo, este mismo marco teórico advierte que el impacto en el aprendizaje depende también de la calidad de la integración pedagógica, lo que refuerza la idea de que no basta con utilizar IA para lograr mejoras homogéneas en todas las dimensiones investigativas.

Por otro lado, las competencias más beneficiadas por el uso de la IA corresponden a las fases de análisis y comunicación científica. En tal sentido, existe la necesidad de diversificar las estrategias de integración para fortalecer también las etapas iniciales del proceso investigativo. En esta línea, Ooi et al. (2025) sostienen que el potencial de la IA generativa se materializa plenamente cuando se combina con estrategias de formación interdisciplinarias y una guía docente activa.

CONCLUSIONES

El análisis comparativo mostró que solo la dimensión de análisis e interpretación presentó diferencias estadísticamente significativas, destacando el grupo de alto uso de IA con un mayor dominio, lo que indica que estas herramientas favorecen especialmente el procesamiento y la comprensión de datos.

Las competencias más fortalecidas en los estudiantes con uso intensivo de IA fueron el diseño metodológico, el análisis e interpretación y la comunicación científica, lo que sugiere un efecto más marcado en las fases operativas y de presentación de resultados que en la formulación del problema o la fundamentación teórica.

En términos globales, el perfil de uso de inteligencia artificial influye de forma diferenciada en las competencias investigativas, potenciando especialmente las habilidades analíticas y de comunicación, pero con menor impacto en las etapas iniciales del proceso de investigación. En tal sentido se evidencia la importancia de un enfoque curricular que promueva un uso formativo y equilibrado de la IA en la educación superior.

FINANCIAMIENTO

No monetario.

AGRADECIMIENTOS

A todos los actores involucrados en la investigación por sus aportes en el análisis documental del presente estudio.

REFERENCIAS CONSULTADAS

Aguirre, G., Esquivel-Gámez, I., Edel Navarro, R., y Veytia-Buchelli, M. G. (2024). La IA en el desarrollo de competencias investigativas en el posgrado. Alteridad, 19(2), 162–172. https://doi.org/10.17163/alt.v19n2.2024.01

Behnamnia, N., Hayati, S., Kamsin, A., Ahmadi, A., y Alizadeh, Z. (2024). Enhancing Students’ Research Skills Through AI Tools and Teacher Competencies: A Mixed-Methods Study. Journal of E-Learning and Knowledge Society, 20(3), 39-55. https://doi.org/10.20368/1971-8829/1135960

Berrios, R., y Márquez, L. (2025). Agente de Inteligencia Artificial Generativa en investigación científica. Un análisis explicativo del aprendizaje en el aula. RIED-Revista Iberoamericana de Educación a Distancia, 28(2). https://doi.org/10.5944/ried.28.2.43545

Bollaert, L. (2025). Artificial Intelligence: Objective or Tool in the 21st-Century Higher Education Strategy and Leadership? Education Sciences, 15(6), 774. https://doi.org/10.3390/educsci15060774

Bracho Fuenmayor, P. L. (2023). Docencia e investigación, binomio de acción en el escenario universitario. Espacio Abierto, 32(1), 97-117. https://doi.org/10.5281/zenodo.7776008

Comas Rodríguez, R. (2025). ¿Es ético el uso de herramientas de inteligencia artificial en el desarrollo de una investigación? Revista Uniandes Episteme, 12(1), 1-3. https://doi.org/10.61154/rue.v11i4.3645

De La Hoz, E., y López Polo, L. (2017). Aplicación de Técnicas de Análisis de Conglomerados y Redes Neuronales Artificiales en la Evaluación del Potencial Exportador de una Empresa. Información Tecnológica, 28(4), 67–74. https://doi.org/10.4067/S0718-07642017000400009

Deroncele, A., Bellido-Valdiviezo, O., Sánchez-Trujillo, M. D. L. Á., Palacios-Núñez, M. L., Rueda-Garcés, H., y Brito-Garcías, J. G. (2024). Ten Essential Pillars in Artificial Intelligence for University Science Education: A Scoping Review. Sage Open, 14(3), 21582440241272016. https://doi.org/10.1177/21582440241272016

Diaz Vera, J. P., Peña Hojas, D. S., Fabara Sarmiento, Z. J., Ruiz Ramírez, A. K., y Macías Mora, D. V. (2023). Estudio comparativo experimental del uso de chatGPT y su influencia en el aprendizaje de los estudiantes de la carrera Tecnologías de la información de la universidad de Guayaquil. Revista Universidad de Guayaquil, 137(2), 51–63. https://doi.org/10.53591/rug.v137i2.2107

Duque-Rodríguez, J. A., Piña-Ferrer, L. S., Isea-Argüelles, J. J., & Comas-Rodríguez, R. (2024). Aprendizaje tecnológico desde los primeros años de escolaridad en la era de la inteligencia artificial. Cienciamatria. Revista Interdisciplinaria de Humanidades, Educación, Ciencia y Tecnología, 10(18), 151-167. https://doi.org/10.35381/cm.v10i18.1247

El Hani, Z., Karroum, J., Elouadi, A., y Moumen, A. (2025). Artificial intelligence in academic research: Benefits, challenges, and ethical dimensions in doctoral studies. Moroccan Journal of Quantitative and Qualitative Research, 7(2). https://doi.org/10.48379/IMIST.PRSM/MJQR-V7I1.55186

Gonzales, J. D. R., Reyna, J. T., Amaya, E. A. V., y Luján, I. G. V. (2025). Evaluation of the Impact of ChatGPT on the Development of Research Skills in Higher Education. International Journal of Learning, Teaching and Educational Research, 24(4), 370–390. https://doi.org/10.26803/ijlter.24.4.18

Huang, Y., Li, S., y Liu, Z. (2025). Can GenAI complement supervisor support in shaping postgraduates’ research experiences? A mixed-methods approach. Studies in Higher Education, 1–19. https://doi.org/10.1080/03075079.2025.2495710

Ilieva, G., Yankova, T., Klisarova-Belcheva, S., Dimitrov, A., Bratkov, M., y Angelov, D. (2023). Effects of Generative Chatbots in Higher Education. Information, 14(9), 492. https://doi.org/10.3390/info14090492

Levene, H. (1960). Contributions to Probability and Statistics: Essays in Honor of Harold Hotelling. En I. Olkin, S. G. Ghurye, W. Hoeffding, W. G. Madow, y H. B. Mann (Eds.), In Contributions to Probability and Statistics: Essays in Honor of Harold Hotelling (pp. 278–292). Stanford University Press. https://doi.org/10.2307/2984135

Ooi, K.-B., Tan, G. W.-H., Al-Emran, M., Al-Sharafi, M. A., Capatina, A., Chakraborty, A., Dwivedi, Y. K., Huang, T.-L., Kar, A. K., Lee, V.-H., Loh, X.-M., Micu, A., Mikalef, P., Mogaji, E., Pandey, N., Raman, R., Rana, N. P., Sarker, P., Sharma, A., … Wong, L.-W. (2025). The Potential of Generative Artificial Intelligence Across Disciplines: Perspectives and Future Directions. Journal of Computer Information Systems, 65(1), 76–107. https://doi.org/10.1080/08874417.2023.2261010

Pavlik, J. V. (2023). Collaborating With ChatGPT: Considering the Implications of Generative Artificial Intelligence for Journalism and Media Education. Journalism & Mass Communication Educator, 78(1), 84–93. https://doi.org/10.1177/10776958221149577

Ríos, P., Ruiz, C., Paulos ., T., y León, R. (2023). Desarrollo de una escala para medir competencias investigativas en docentes y estudiantes universitarios. Areté, Revista Digital del Doctorado en Educación de la Universidad Central de Venezuela, 9(17). https://doi.org/10.55560/ARETE.2023.17.9.7

Robie, C., Meade, A. W., Risavy, S. D., y Rasheed, S. (2022). Effects of Response Option Order on Likert-Type Psychometric Properties and Reactions. Educational and Psychological Measurement, 82(6), 1107–1129. https://doi.org/10.1177/00131644211069406

Selan, J., y Metljak, M. (2023). Developing and Validating the Competency Profile for Teaching and Learning Research Integrity. Center for Educational Policy Studies Journal, 13(3), 33–74. https://doi.org/10.26529/cepsj.1618

Soliman, M., Ali, R. A., Khalid, J., Mahmud, I., y Ali, W. B. (2024). Modelling continuous intention to use generative artificial intelligence as an educational tool among university students: Findings from PLS-SEM and ANN. Journal of Computers in Education. https://doi.org/10.1007/s40692-024-00333-y

Taber, K. S. (2018). The Use of Cronbach’s Alpha When Developing and Reporting Research Instruments in Science Education. Research in Science Education, 48(6), 1273–1296. https://doi.org/10.1007/s11165-016-9602-2

Zawacki-Richter, O., Marín, V. I., Bond, M., y Gouverneur, F. (2019). Systematic review of research on artificial intelligence applications in higher education – where are the educators? International Journal of Educational Technology in Higher Education, 16(1), 39. https://doi.org/10.1186/s41239-019-0171-0

©2025 por los autores. Este artículo es de acceso abierto y distribuido según los términos y condiciones de la licencia Creative Commons Atribución-NoComercial-CompartirIgual 4.0 Internacional (CC BY-NC-SA 4.0) (https://creativecommons.org/licenses/by-nc-sa/4.0/)